做SEO肯定要关注收录。有收录,不一定有好的排名;但不收录,就绝对不存在有排名的可能性。

早前我分享过一些关于网页收录的SEO实践,很多时候是从单个页面出发,特别讲到的是新页面迟迟不被收录的情况。而这次的分享是从整站的角度去看总收录数如何影响SEO。

看网站整体收录数的意义在于:

1、评估网站整体的健康情况:如果收录数远远低于网站实际网页数,那往往是因为整个网站质量低。

2、及时监控网站是否出现了大的异常:比如网站被惩罚了、或者错误设置noindex标签/robots文件,都会导致网站收录数出现骤降。

3、跟进整站SEO优化的效果提升:如果你接手了一个很烂的网站,在做了一轮整体的SEO大优化后,可以通过查看收录数是否有大幅度提升作为重要的效果衡量指标之一。

查询整站页面被谷歌收录数常用的方式有两种:

1、site命令,即site:http://domain.com

2、查看Google Search Console的Indexing(中文:编制索引,下面统一用中文的说法)报告

之前收到过以下关于整站收录的一些问题:

为什么收录数低于网站实际网页数?

某些页面前阵子还被收录了,但是今天查却发现收录没了。

为什么用site命令查出来的页面数和Search Console不一致,应该以哪个为准?

Search Console编制索引报告显示收录数变动特别大,不知道问题出现在哪里。

Search Console编制索引报告提示我有大量的自动重定向/404页面,该如何处理?

下面就以Q&A的方式来说说我是怎么处理以上这些问题的。

Q1:为什么收录数低于网站实际网页数?

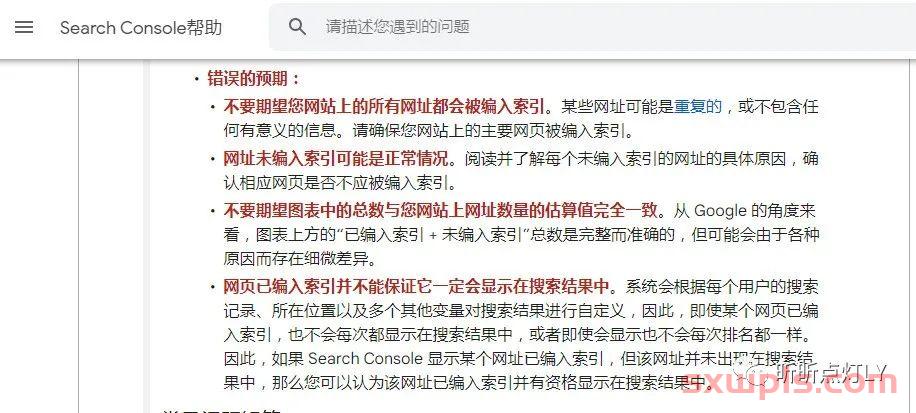

Answer: Google不会收录你所有的网页。在Search Console 编制索引报告的帮助文档,有明确地提到这一点:

所以收录数比网页数低并非都是异常,那什么情况才是异常呢?

根据Google的John Mueller的说法:网站 20% 的网页未被编入索引属于正常范围。

也就是说,假设你的网站实际上有100个网页,收录的网页在80个以上,并且你的重点页面都被收录了,那你就不需要过于追求更高的收录率了。

敲重点:必须确保你的重点页面给谷歌收录了。

那当发现超过20%以上的网页不被谷歌收录,该如何排查呢? 在Google Search Console的编制索引版块,有很直接地提示网页未被编入索引的原因。点击原因细项,可以看到是哪些网页受到了影响。

如果确定是因为异常操作导致的和技术有关的问题,比如重定向或404,可以把这些异常页面下载下来,给到网站开发去处理。

如果你发现很多页面因“已抓取 - 尚未编入索引”和“已抓取 - 尚未编入索引”导致不收录,通常是因为你的整体网站质量低或者单个页面质量低。

单个页面质量低很显而易见,常见的表现为:原创度低,内容很简短,废话较多而有价值的内容少,语言表达不地道甚至有明显的语法错误。

然后你可能会发现,某单个页面的质量不算很高 ,但也绝对算不上低,符合100%原创度等基本SEO要求,但是也没有被索引。原因很可能出现在网站整体质量上:谷歌并不是认为你这个页面质量很低,而是认为你整个网站的质量有点低,因为整体网站质量可以决定网站有多少页面被编入索引。

提高整站质量可以从内容、技术、外链等方面入手,这是一个比较大的范畴,这里不展开说。可以举个我自己思考的例子:去年8月谷歌推出helpful content update新搜索算法时,表示“删除无用的内容可能有助于提高其他内容的排名”。结合到因为整站质量影响单个质量并不是很差的页面收录这个问题,我认为删除无用的页面是有助于提高质量不算低的页面收录。

Q2:某些页面前阵子还被收录了,但是今天查却发现收录没了。

Answer:排除技术的原因,那大概率是因为页面质量低。

但如果是质量问题,为什么之前谷歌还会收录你的页面,而不是在第一次抓取的时候就直接不收录呢?

原因在于:如果谷歌没有将该页面编入索引,那么他们不会真正知道它是高质量还是低质量。

有实操过SEO的人可能会发现:有时候新页面在刚被收录时,排名还不错 ;可没高兴几天,排名比刚收录的时候跌了好几页。

和上面的先索引后取消索引是一个道理,谷歌需要借助一些真实用户访问页面的数据反馈来帮助他们进一步确定该页面是不是真正的高质量。(注:并非谷歌公开的说明,而是实践中的观察)

也就是说,谷歌后来发现你的页面质量并不好,就从他们的数据库里把你的页面给删除了,所以你发现原本有收录的页面现在不被收录。

可尝试通过优化内容提高页面质量,再提交给谷歌审查,看看能不能让谷歌再收录。

Q3:为什么用site指令查出来的页面数和Search Console不一致,应该以哪个为准?

Answer:Google的说法是把site指令作为参考,准确的数据以Search Console索引报告为主。

我之前还专门研究过这个问题。简单说一下我的研究结论:我认为site指令查出来的收录数还是非常值得关注的指标。因为有些页面在Search Console中显示被收录了,而用site指令查不出来的时候,在Google搜索引擎搜该页面的网址也是搜不出来的。换句话说:用site指令查不到收录的网页,几乎不可能获取到排名和流量。

我们不可能有精力关注到网站的每一个页面。回答问题1时强调的一个重点:必须确保你的重点页面被谷歌收录了。在这里进一步要强调的重点是:必须确保你的重点页面用site指令可以查到被收录。(注:非谷歌官方说法,而是我个人的实践观察)

Q4:Search Console编制索引报告显示收录数变动特别大,不知道问题出现在哪里?

Answer:以下是我以往排查的方法,供参考

#1 通过路径:Google Search Console -> 编制索引 -> 网页 -> 所有已提交的网页 -> 未编入索引 -> 原因

找到有大量未编入索引的网页,进一步细分排查。

#2 打开Google 搜索排名更新列表,看看谷歌这段时间是否推出/更新了算法,我的网站是不是刚好有些行为明显触犯了算法?

Q5:Search Console编制索引报告提示我有大量的自动重定向/404页面,该如何处理?

Answer: 这属于技术SEO的问题。建议SEO人员先自己过一遍,确认是开发的问题,再把问题提交网站开发人员处理。

SEOer还是很有必要懂一些常用的技术SEO操作,因为如果你不懂,直接把问题抛给开发人员,开发人员也很可能不懂。谷歌搜索中心有很全面的教程,我在之前的文章里也分享过我在SEO工作中常用到的技术SEO。

在掌握了一定技术SEO的基础上,你会发现Search Console编制索引报告里提示的很多关于重定向问题其实是不用管它的。还有404的页面,谷歌也曾表明网站出现 404 错误是正常的,不会将它们视为负面排名因素。

你要做的是结合网站的实际情况,判断出现的自动重定向或者404页面等问题,是不是你们有意为之的,会不会影响用户体验和谷歌抓取。如果确认没问题,不用去找开发人员;即使在编制索引报告一直有提示,你也不需要担心。

比如我网站现在被提示有4.5万的网页是重复网页,但是我的SEO一点都没有受到影响。

经过排查后,我发现这里的重复网页大部分是来自我们的登录页面,当用户访问登录着陆页时自动生成的。我找网站开发的同事确认过,实际在网站的后台没有这样的页面,也查不到为什么会生成这样的页面。保险起见,我在robots文件里做了屏蔽。做了屏蔽后,谷歌还是继续抓,但也会不时删掉一些之前抓到的这类页面。长期观察下来,我确定并不会对我的网站SEO造成负面的影响。

所以当你看到未被编入索引的页面量特别大,有好几万,不要太担心,有时候是因为谷歌的抓取和判断没那么智能。只要确保当前你网站SEO不受影响,对提示的页面进一步分析和处理就好。

在网页索引编制报告里,有“所有已知网页”、“所有已提交的网页”、“仅未提交的网页”,以及站点地图过滤器(如果你有站点地图的话)几个选项。

新手看到这些选项可能会有点迷惑。要搞清楚首先需要知道它们的定义是什么,在Search Console帮助文档有很详细的解释。

简单来说,“所有已提交的网页”是指在站点地图中列出的网址。“仅未提交的网页”是指不在站点地图列出来的网址。而“所有已知网页”是“所有已提交的网页”和“仅未提交的网页”的总和。

报告默认显示的是“所有已知网页”。你很可能会发现不同的筛选器的结果相差非常大。那么我们上面说到网站 20% 的网页未被编入索引属于正常范围,到底是看哪一项?我是看第二项“所有提交的网页”,我网站的收录率是93.5%,在正常范围内。这里需注意:确保把你希望被索引的正常网页都放到网站地图里,这样统计出来的索引率才会准确。

本文链接:https://www.sxwpls.com/9672.html ,转载需注明文章链接来源:https://www.sxwpls.com/

-

喜欢(0)

-

不喜欢(0)